随着数字化转型的深入,企业信息系统正朝着松耦合、高可用的微服务架构演进。在这一进程中,服务间的可靠、高效通信成为关键。Apache Kafka,作为一个分布式的流处理平台与消息中间件,凭借其独特的高性能设计,已成为微服务集成与异步通信的核心基础设施。本文将探讨Kafka的高性能设计哲学,及其在构建现代化、高性能信息系统集成服务中的核心作用。

一、Kafka高性能设计的核心支柱

Kafka的高性能并非偶然,而是源于其精心的架构设计,主要集中在以下几个方面:

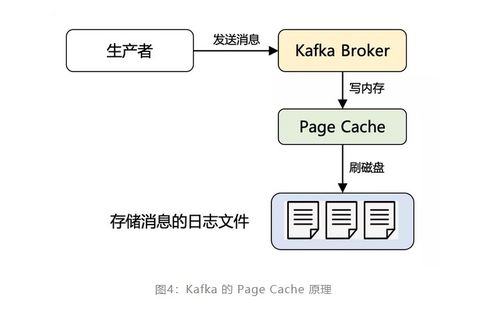

- 顺序磁盘I/O与零拷贝技术:与传统数据库的随机读写不同,Kafka将消息持久化到磁盘时采用顺序追加写入的方式,其速度甚至可以超过内存的随机读写。在消费者读取时,Kafka利用操作系统的零拷贝(Zero-copy) 技术,将磁盘文件的数据直接通过网络发送给消费者,避免了内核缓冲区与用户缓冲区之间的多次拷贝,极大降低了CPU开销和上下文切换。

- 分区(Partition)与并行机制:Topic在物理上被划分为多个分区,分布在不同的Broker上。这种设计实现了数据的水平拆分和负载均衡。生产者和消费者可以并行地向多个分区读写数据,从而线性提升系统的整体吞吐量。这是支撑海量数据流处理的基础。

- 基于日志的持久化与批处理:Kafka将所有消息以仅追加(append-only)的日志形式存储。生产者发送消息时,并非每条消息都立即触发网络和磁盘I/O,而是会先在客户端进行批量压缩,积累到一定大小或时间后再批量发送。这种批处理机制显著减少了网络往返和I/O操作次数。

- 高效的消费者组模型:Kafka的消费者采用“拉取(Pull)”模式,可以自主控制消费速率和时机。消费者组(Consumer Group)机制使得同一组内的消费者可以共同消费一个Topic的多个分区,实现消费能力的弹性伸缩和高可用,避免了消息队列常见的“广播”带来的性能瓶颈。

二、在信息系统集成服务中的典型应用场景

在微服务架构的信息系统集成中,Kafka扮演着“中枢神经系统”的角色:

- 服务解耦与异步通信:订单服务在创建订单后,只需将“订单创建”事件发布到Kafka的

order-eventsTopic,而库存服务、物流服务、风控服务等作为独立的消费者,异步地订阅并处理该事件。服务间无需直接HTTP/RPC调用,实现了彻底解耦,提高了系统的整体弹性和可维护性。

- 事件溯源与数据流管道:Kafka可以作为所有领域事件的持久化存储,构建事件溯源(Event Sourcing) 系统。所有改变系统状态的事件都被顺序记录,为审计、数据回放和构建新的数据视图提供了可能。Kafka Connect可以方便地将数据从数据库、日志文件导入Kafka,或从Kafka导出到数据仓库(如Hadoop、ES),构建实时数据管道。

- 流处理与实时分析:结合Kafka Streams或Flink等流处理框架,可以对流经Kafka的数据进行实时处理。例如,在用户行为分析系统中,实时计算点击率、统计在线人数;在风控系统中,实时分析交易流水,识别异常模式。

三、构建高性能集成服务的实践要点

要充分发挥Kafka的性能优势,在系统集成设计中需注意:

- 合理的Topic与分区规划:根据业务域和数据吞吐量设计Topic,避免“大杂烩”。分区数是Kafka并行度的上限,需要根据预期的消费者数量和吞吐量进行合理设置,并预留扩容空间。

- 优化生产与消费配置:生产者端合理配置

batch.size和linger.ms以优化批处理;根据对可靠性的要求选择acks配置(如acks=1在性能与可靠性间取得平衡)。消费者端注意控制fetch.min.bytes以提升拉取效率,并做好偏移量管理。 - 保障高可用与监控:Kafka集群本身应部署多副本(Replication),确保Broker故障时数据不丢失、服务不间断。必须建立完善的监控体系,关注集群吞吐量、网络IO、磁盘使用率、消费延迟(Lag)等关键指标。

- 端到端的语义保障:根据业务需求,明确消息传递的语义(如至多一次、至少一次、恰好一次),并通过幂等生产者、事务API等机制予以实现。

###

Apache Kafka通过其以吞吐量和扩展性为核心的设计,为微服务架构提供了强大的异步通信骨干。在复杂的信息系统集成服务中,它不仅是消息传递的管道,更是实时数据流的统一平台。深入理解其高性能原理,并在此基础上进行合理的架构设计与运维,是构建敏捷、可靠、能够应对海量数据挑战的现代信息系统的关键所在。将Kafka融入系统集成蓝图,意味着选择了面向未来流式数据世界的高性能路径。